Google acelera com Gemini 3 Flash e empurra a disputa das IAs

Mais desempenho onde importa

O Google anunciou o Gemini 3 Flash, um modelo pensado para ser rápido, mais acessível e eficiente em tarefas do dia a dia.

A novidade chega como uma evolução direta da linha Flash e, ao mesmo tempo, como uma peça estratégica: o Gemini 3 Flash passa a ser o modelo padrão no app Gemini e no modo de IA da Busca, mirando usos em grande escala sem abrir mão de desempenho em benchmarks importantes.

O que muda com o Gemini 3 Flash?

A proposta do Flash é clara: ser o “modelo de trabalho”, aquele que aguenta volume. Ele foi desenhado para responder com mais velocidade e reduzir custo por uso, ao mesmo tempo em que melhora em avaliações de raciocínio e multimodalidade, com desempenho que encosta em modelos de ponta em algumas métricas.

Na prática, isso significa um modelo mais pronto para rotinas repetíveis, automações, suporte e tarefas que precisam de resposta rápida. O Google também destaca ganhos em compreensão de intenção e em respostas mais visuais, com elementos como imagens e tabelas quando fizer sentido.

Como os benchmarks posicionam o modelo?

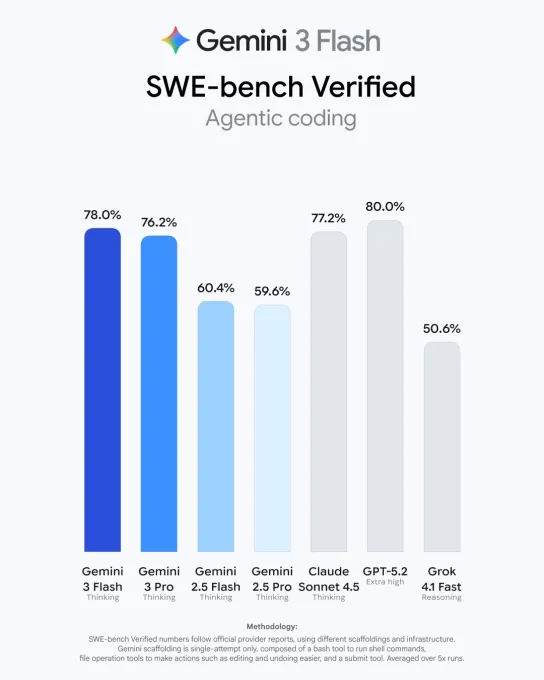

Nos resultados divulgados, o Gemini 3 Flash aparece como um salto relevante em relação ao Flash anterior, especialmente em avaliações de conhecimento geral e raciocínio. Em testes voltados para “saber fazer” em múltiplos domínios, ele se aproxima de modelos de fronteira e encurta a distância para versões Pro.

A tabela abaixo resume os números mencionados para benchmarks e preço por tokens, além de uma comparação rápida com a geração anterior.

Onde o Gemini 3 Flash vai aparecer para o público?

O Google colocou o Gemini 3 Flash como padrão no app Gemini em escala global, substituindo o Flash anterior. A ideia é que o usuário comum já pegue o modelo “rápido” por padrão, mantendo a opção Pro no seletor para quem quer focar em tarefas como matemática e programação.

O modelo também entra no modo de IA da Busca, com foco em respostas mais visuais e melhor leitura de intenção. Em usos multimodais, a promessa é interpretar vídeo curto, áudio e imagens para orientar, analisar e responder com mais contexto.

A Google mostra, nessa postagem na rede social X, o desempenho do Gemini 3 Flash comparado ao modelo 2.5 Pro:

Speed test: Gemini 3 Flash vs. Gemini 2.5 Pro ⏱️

— Google (@Google) December 17, 2025

We put our new Gemini 3 Flash model (left) up against Gemini 2.5 Pro (right) in @GoogleAIStudio, so you can watch the difference in near real-time.

Watch them go head-to-head ↓ pic.twitter.com/vamCtNGKHr

Como fica para empresas e desenvolvedores?

Para quem usa em escala, o Flash aparece como aposta de “fluxo de trabalho”, bom para tarefas repetíveis, análise de vídeo, extração de dados e perguntas visuais. Ele fica disponível via Vertex AI e Gemini Enterprise, além de chegar para desenvolvedores em modo de prévia via API.

Também foi citado suporte no Antigravity, a ferramenta de programação do Google. Para entender onde isso encaixa no mundo real, estes são os usos que mais combinam com o posicionamento do Flash:

- atendimento e copilotos com alto volume de mensagens

- processos internos com extração e classificação de informações

- análise rápida de imagens, vídeos curtos e áudio

- prototipagem e iteração de ideias com respostas rápidas

- tarefas em lote que pedem custo previsível

Gemini 3 Flash is rolling out to developers now ⚡

— Google (@Google) December 17, 2025

3 Flash is our latest model with frontier intelligence built for speed. With strong multimodal, coding and agentic features, it not only enables everyday tasks with improved reasoning, but also is our most impressive model for… pic.twitter.com/woWX0ZFFys

Por que esse lançamento mexe com a disputa de modelos?

O movimento de tornar o Flash padrão no app e na Busca aumenta a chance de adoção em massa, porque coloca o modelo no caminho natural do usuário. Ao mesmo tempo, reforça a guerra de performance, preço e velocidade: não basta ser “bom”, precisa ser rápido, barato e presente onde as pessoas já estão.

No fim, a mensagem é que a competição está apertando e empurrando a régua para cima. Para o usuário, isso tende a se traduzir em modelos mais capazes no cotidiano, com respostas melhores, mais multimodais e mais eficientes em custo ao longo do uso.

Os comentários não representam a opinião do site; a responsabilidade pelo conteúdo postado é do autor da mensagem.

Comentários (0)